"내 개인적인 대화 내용을 AI 서버에 보내는 게 좀 찜찜한데...", "인터넷 안될 땐 무용지물이잖아!", "매달 나가는 구독료도 부담스러워..." 혹시 이런 생각해 보신 적 없으신가요? 클라우드 AI의 편리함 이면에는 분명 이런 고민들이 존재합니다. 하지만 만약, 이 모든 걱정 없이 나만의 AI를, 내 컴퓨터 안에서, 그것도 무료로 돌릴 수 있다면 어떨까요? KT가 공개한 한국어 특화 LLM '믿음(midm)'과 'LM Studio'라는 마법 같은 도구가 만나 이 꿈을 현실로 만들어줍니다. 지금부터 커피 한잔 준비하시고, 당신의 PC를 최첨단 AI 서버로 변신시키는 여정을 함께 떠나보시죠! 🚀

1. 로컬 AI, 왜 갑자기 뜨는 걸까? (feat. 프라이버시 & 무료) 🕵️♂️

우리가 흔히 쓰는 ChatGPT나 Claude는 거대한 데이터 센터의 수많은 컴퓨터 위에서 돌아갑니다. 우리가 질문을 보내면, 그 질문이 인터넷을 통해 서버로 날아가고, 답변을 받아오는 방식이죠. '로컬 AI'는 이 모든 과정을 내 책상 위 컴퓨터 안에서 끝내버리는 개념입니다. 데이터가 내 컴퓨터 밖으로 한 발짝도 나가지 않으니 개인정보나 회사 기밀 유출 걱정이 원천적으로 차단됩니다. 인터넷 연결이 필요 없고, 월 구독료도 없죠. 그야말로 '나만의 것'이라는 완전한 소유권과 제어권을 갖게 되는 겁니다.

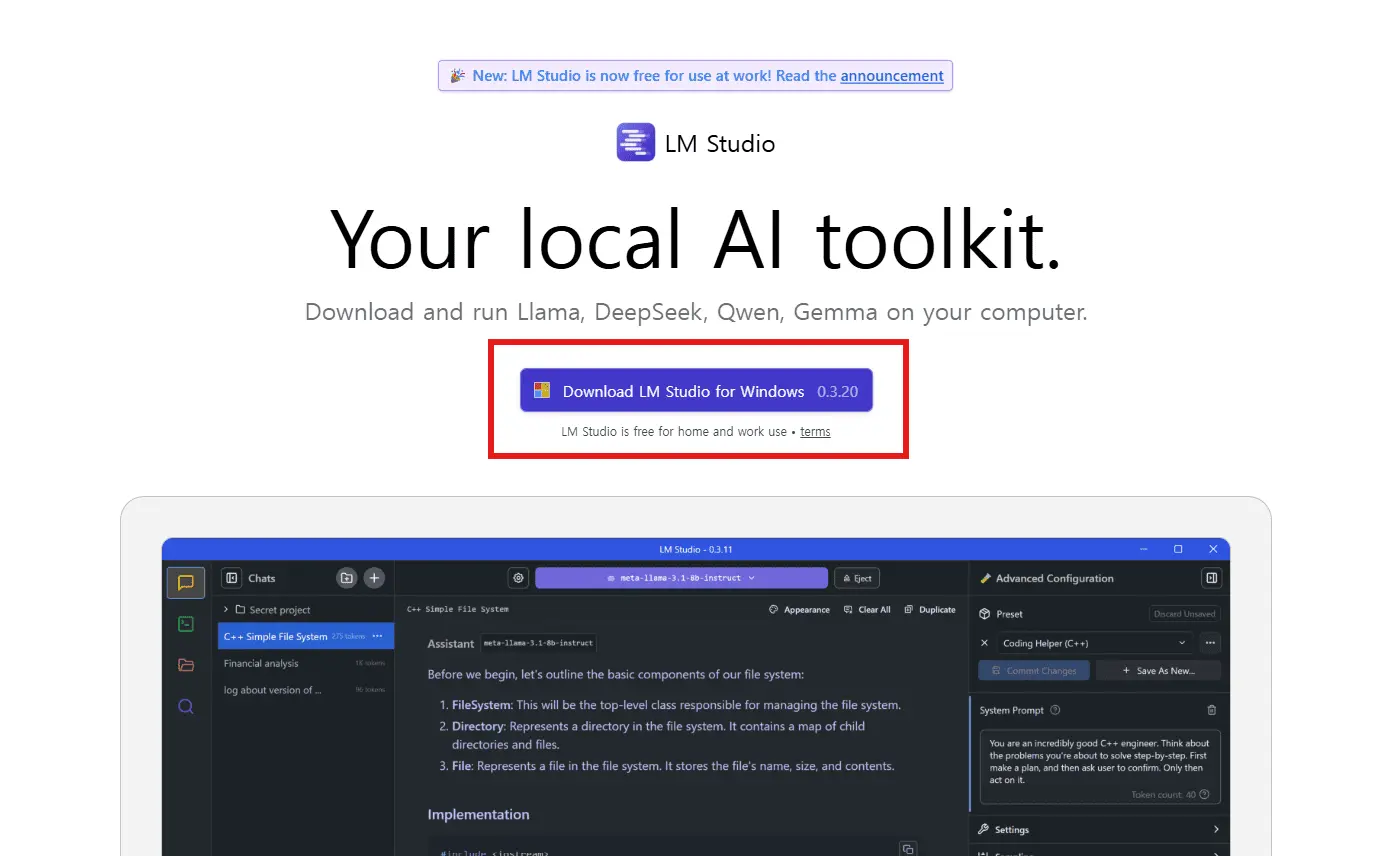

2. 초보자를 위한 AI 놀이터: LM Studio 설치하기 🏟️

로컬 AI를 구동하려면 원래 복잡한 설정이 필요했지만, LM Studio가 등장하면서 모든 게 바뀌었습니다. 코딩 지식이 전혀 없어도, 마치 앱 스토어에서 앱을 다운받듯 LLM을 설치하고 실행할 수 있게 해주는 혁명적인 프로그램이죠.

설치는 간단합니다. LM Studio 공식 홈페이지에 접속해서 여러분의 운영체제에 맞는 파일을 다운로드하고 실행하면 끝! 최소 16GB의 시스템 메모리(RAM)를 권장하지만, 오늘 우리가 다룰 '양자화' 모델을 활용하면 8GB RAM에서도 충분히 즐길 수 있습니다.

3. 국산 AI '믿음' 내 PC에 입주시키기 (Step-by-Step) 🏠

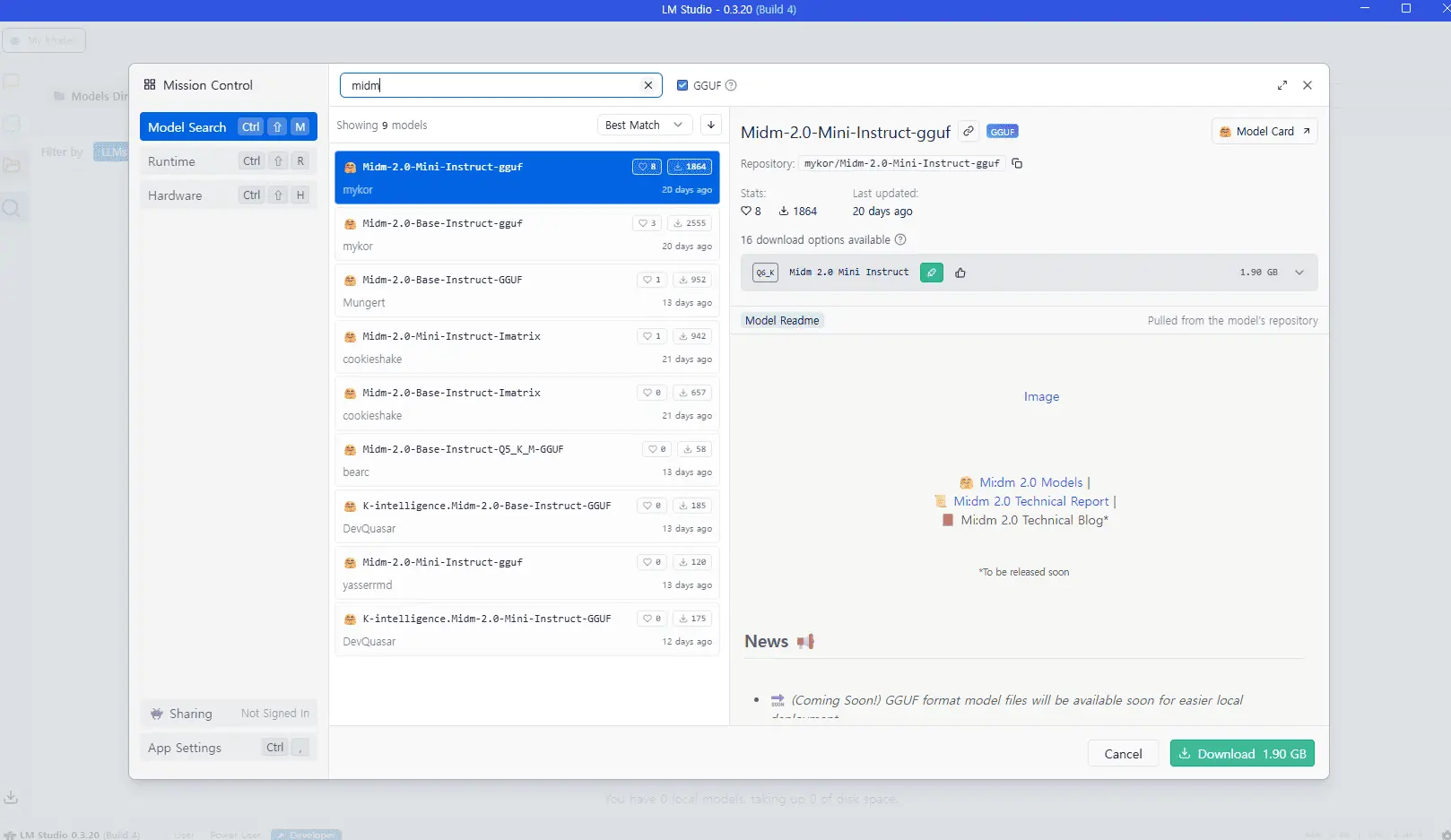

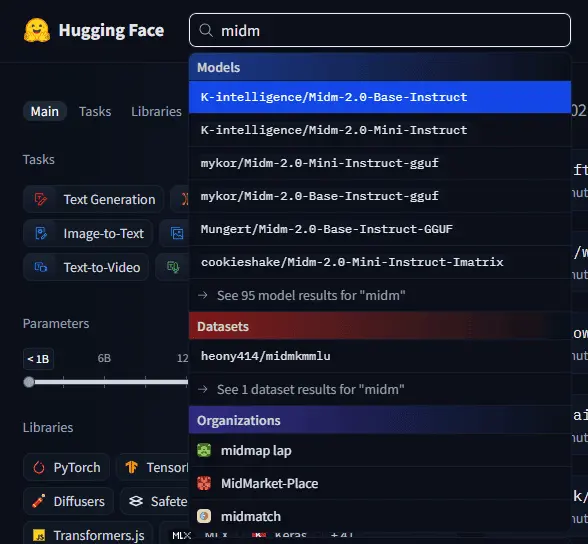

LM Studio 설치가 끝났다면, 이제 오늘의 주인공 '믿음'을 초대할 차례입니다.

- 모델 검색: LM Studio를 실행하고 왼쪽 메뉴에서 집 모양 아이콘(검색)을 클릭하세요. 검색창에

K-intelligence/Midm이라고 입력합니다. KT가 공식적으로 공유한 모델들이 나타납니다. - 모델 선택:

Midm-2.0-Base-Instruct-GGUF와 같이 이름에 GGUF가 포함된 모델을 찾으세요. GGUF는 로컬 PC 환경에 최적화된 만능 파일 형식입니다. - 버전 선택 및 다운로드: 모델을 클릭하면 오른쪽에 파일 목록이 나타납니다. F16, Q8_0, Q4_K_M 등 알 수 없는 이름들이 보일 겁니다. (걱정 마세요, 바로 다음 섹션에서 전부 설명해 드립니다!) 일단은 Q4_K_M 이나 Q5_K_M 버전 옆의 'Download' 버튼을 눌러보세요. 용량과 성능 사이의 가장 이상적인 시작점입니다.

- 대화 준비: 다운로드가 완료되면 왼쪽 메뉴에서 말풍선 아이콘(채팅)을 클릭합니다. 화면 상단의 'Select a model to load' 버튼을 눌러 방금 다운받은

midm모델을 선택하면 모든 준비가 끝납니다!

GGUF 양자화란?

쉽게 말해 'AI 다이어트'입니다. 모델의 성능 저하를 최소화하면서 파일 크기와 메모리 사용량을 획기적으로 줄이는 기술이죠. 덕분에 우리는 고사양 서버 없이 개인용 PC에서도 거대 언어 모델을 실행할 수 있게 되었습니다.

4. "Q2? Q8? F16?" 알쏭달쏭 모델 파일, 완벽 해부! 🔬

다운로드 목록을 보면 암호 같은 파일 이름 때문에 혼란스러우셨을 겁니다. '양자화(Quantization)' 레벨을 나타내는 이 이름들의 의미를 알면, 내 PC 사양에 딱 맞는 최적의 모델을 직접 고를 수 있게 됩니다.

| 버전 이름 | 설명 | 추천 대상 |

|---|---|---|

| F32 / F16 | 양자화되지 않은 원본(F32) 또는 절반 정밀도(F16) 버전. 최고의 품질을 제공하지만 파일 크기가 매우 크고 엄청난 RAM을 요구합니다. | 고성능 워크스테이션, 전문가 |

| Q8_0 | 8비트 양자화. 원본(F16)과 거의 차이 없는 품질을 보여주면서 크기는 훨씬 작습니다. 품질 저하를 원치 않을 때 훌륭한 선택입니다. | 32GB 이상 RAM 사용자, 품질 우선 |

| Q6_K | 6비트 양자화. 품질과 성능 사이의 균형이 매우 뛰어납니다. | 16GB 이상 RAM 사용자, 균형 중시 |

| Q5_K_M | 5비트 양자화. 많은 전문가들이 '가성비의 왕'으로 꼽는 버전입니다. 적당한 크기에 매우 뛰어난 성능을 보여줍니다. | 16GB RAM 사용자, 최적의 선택 |

| Q4_K_M | 4비트 양자화. 가장 대중적인 버전으로, 일반적인 노트북(16GB RAM)에서도 원활하게 작동합니다. 입문자에게 강력 추천합니다. | 8GB~16GB RAM 사용자, 입문자 |

| Q3_K_S / Q2_K | 3비트/2비트 양자화. 파일 크기가 매우 작지만, 성능 저하가 눈에 띌 수 있습니다. '어 똑똑하지 않은데?'라고 느낄 수 있어요. | RAM이 매우 부족한 구형 PC, 실험용 |

*용어 설명: 'K'는 최신 양자화 기술(K-Means)을 의미하며, 'S', 'M', 'L'은 Small, Medium, Large로, 같은 비트 내에서도 세부적인 품질 차이를 나타냅니다. 일반적으로 'M'이 가장 무난한 선택입니다.

5. 실전! '믿음' 로컬 테스트 심층 분석 (feat. Q4_K_M) 🕵️♀️

자, 그럼 실제로 '믿음'이 얼마나 똑똑한지, 제 M2 맥북에어(16GB RAM)에서 Q4_K_M 모델을 가지고 본격적으로 테스트해 보겠습니다.

5.1. 한국어 뉘앙스 테스트: 역시 국산이 최고!

먼저 한국어 모델의 자존심, 뉘앙스 파악 능력을 확인해 봤습니다. 직장 생활에서 누구나 겪을 법한 상황을 제시했죠.

# 프롬프트

"거래처에 보낼 이메일 초안 좀 써줘. 내용은 우리가 제안한 디자인 시안 A, B, C 중에 B안으로 최종 결정됐다는 거야. 근데 A안을 강력하게 밀었던 상대팀 김대리님이 기분 나쁘지 않게, 그분의 안목도 존중하는 뉘앙스를 꼭 포함해줘."

# 믿음 AI의 답변 (요약)

제목: [귀사명] 디자인 시안 최종 선정 관련 안내

(전략)... 보내주신 시안 모두 깊이 있는 고민과 뛰어난 감각이 돋보였습니다. 특히 A 시안이 보여준 독창적인 접근 방식은 저희에게 많은 영감을 주었습니다. 김대리님의 높은 안목 덕분에 저희 프로젝트의 격이 한층 더 높아질 수 있었습니다.

내부적으로 장시간 논의한 끝에, 이번 프로젝트의 방향성과 가장 잘 부합하는 B 시안으로 최종 결정하게 되었습니다. ... (후략)

와, 정말 감탄했습니다. 👏 단순히 사실만 전달하는 게 아니라, A안을 칭찬하며 상대방의 기분을 배려하는 '사회생활 만렙'의 화법을 구사하네요. 이런 미묘한 감정선은 외국산 모델들이 쉽게 따라 하기 힘든 영역이죠.

5.2. 창의력 및 코딩 테스트: 가능성과 한계

이번엔 창의력과 기술적인 능력을 확인해 봤습니다. 간단한 파이썬 코드 작성을 요청했습니다.

# 프롬프트

"내 다운로드 폴더에 있는 모든 .zip 파일의 압축을 풀고 원본 zip 파일은 삭제하는 파이썬 코드 만들어줘."

# 믿음 AI의 답변

import os

import zipfile

download_folder = 'C:/Users/YourUser/Downloads' # 이 부분은 실제 경로로 변경해주세요

for filename in os.listdir(download_folder):

if filename.endswith('.zip'):

zip_path = os.path.join(download_folder, filename)

try:

with zipfile.ZipFile(zip_path, 'r') as zip_ref:

# 압축 해제할 폴더를 지정합니다 (예: zip 파일과 같은 이름의 폴더)

extract_path = os.path.join(download_folder, filename[:-4])

os.makedirs(extract_path, exist_ok=True)

zip_ref.extractall(extract_path)

print(f"'{filename}' 압축 해제 완료.")

os.remove(zip_path) # 원본 zip 파일 삭제

print(f"'{filename}' 원본 파일 삭제 완료.")

except zipfile.BadZipFile:

print(f"'{filename}'은(는) 유효한 zip 파일이 아닙니다.")

except Exception as e:

print(f"'{filename}' 처리 중 오류 발생: {e}")

꽤 괜찮은 코드를 내놓았습니다. 에러 처리와 같은 디테일까지 신경 쓴 모습이 인상적입니다. 하지만 복잡한 알고리즘이나 최신 라이브러리를 활용하는 코드는 아직 버거워하는 모습을 보이기도 했습니다. 창의적인 글쓰기 능력은 준수했지만, 가끔 예측 가능한 상투적인 표현을 쓰는 경향이 있었습니다.

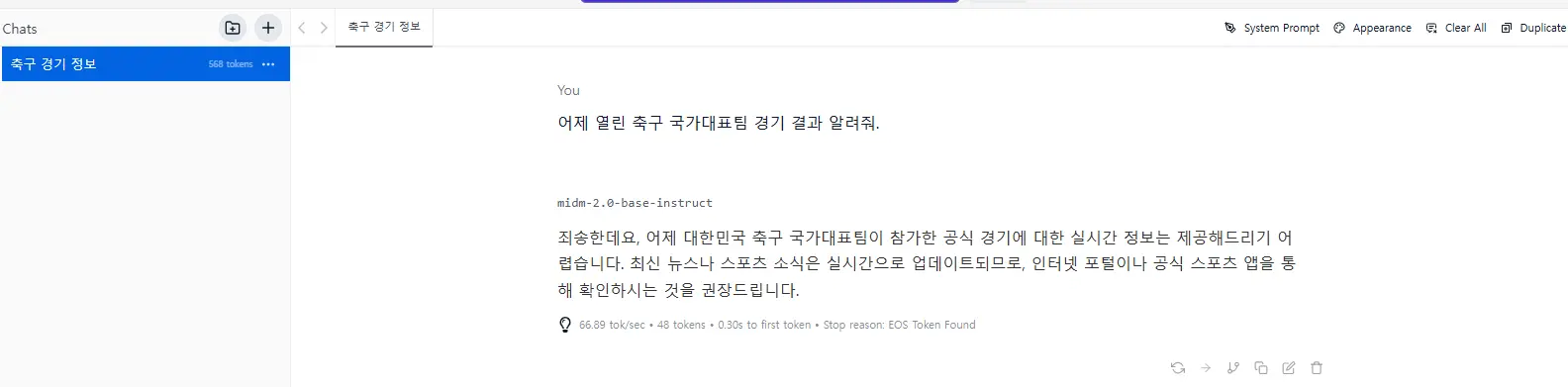

5.3. 한계점 테스트: 최신 정보와 복잡한 추론

마지막으로, 로컬 모델의 명확한 한계를 확인해 봤습니다.

"어제 열린 축구 국가대표팀 경기 결과 알려줘."

결과는? 당연히 모릅니다. '믿음'은 2023년까지의 데이터로 학습되었고, 인터넷에 연결되어 있지 않기 때문입니다. 이는 로컬 모델의 단점이라기보단, 실시간 정보가 아닌 내장된 지식을 활용하는 특성으로 이해해야 합니다.

6. 보너스: LM Studio 설정 만져보기 (나만의 AI 만들기) 🎨

LM Studio의 진짜 재미는 바로 '설정'에 있습니다. 채팅창 오른쪽 패널에서 몇 가지 값만 조절하면 AI의 성격을 바꿀 수 있습니다.

- System Prompt: AI의 기본 역할을 정해주는 지시문입니다. 예를 들어, "너는 조선시대의 왕처럼 말하는 AI 비서다." 라고 입력하면 AI의 말투가 근엄하게 바뀝니다. "넌 모든 대답을 영어로 해야 해." 라고 하면 순식각에 영어 선생님이 되죠.

- Temperature (창의성 온도): 값을 높일수록 (예: 1.2) AI가 더 창의적이고 예측 불가능한 답변을 합니다. 낮출수록 (예: 0.5) 더 정해지고 일관된 답변을 하죠. 시를 쓰게 할 땐 높이고, 보고서를 요약할 땐 낮추는 식으로 활용해보세요.

이 설정들을 이것저것 만져보며 나만의 AI 페르소나를 만들어보는 것은 로컬 AI를 즐기는 최고의 방법 중 하나입니다.

마무리: AI 독립 만세! 다음 단계는? 🥳

축하합니다! 여러분은 이제 클라우드에 종속되지 않은 'AI 독립'을 이루셨습니다. KT의 '믿음'과 LM Studio를 통해 여러분의 PC는 강력한 생산성 도구이자, 무한한 가능성을 탐험할 수 있는 AI 연구소로 재탄생했습니다.

오늘 배운 내용을 바탕으로 다양한 모델과 양자화 버전, 그리고 LM Studio의 설정을 테스트하며 나에게 가장 잘 맞는 조합을 찾아보세요. 이것이 바로 로컬 AI의 가장 큰 재미입니다. 이제 여러분의 창의력과 상상력만이 한계일 뿐입니다. 즐거운 AI 생활 되세요! 😉