2026년 2월 16일, 중국의 전자상거래 거인 Alibaba가 설 연휴를 앞두고 AI 업계에 폭탄을 투하했습니다. 바로 차세대 AI 모델 Qwen 3.5의 등장입니다. 3970억 개의 총 파라미터를 자랑하는 이 거대한 MoE(Mixture of Experts) 모델은, 실제로는 단 170억 개의 파라미터만 활성화시키는 효율적인 설계로 GPT-4, Claude Opus 4.5, Gemini 3 Pro와 어깨를 나란히하는 성능을 보여주고 있습니다. 단순한 챗봇을 넘어 에이전틱 AI(Agentic AI) 시대를 겨냥한 이 괴물 같은 모델의 모든 것을 파헤쳐봅니다.

Qwen 3.5의 등장: 중국 AI 전쟁의 새로운 장

2026년 2월 16일, Alibaba Cloud는 Model Studio 플랫폼을 통해 Qwen 3.5를 공식 출시했습니다. 이 시점의 선택은 결코 우연이 아니었습니다. 중국의 최대 명절인 설 연휴를 일주일 앞둔 이 시기, ByteDance의 Doubao 2.0, Zhipu AI, MiniMax 등 중국 빅테크 기업들이 잇따라 신규 모델을 내놓으며 치열한 경쟁을 벌이고 있었기 때문입니다.

특히 지난해 DeepSeek의 R1 모델이 글로벌 AI 시장에 지각변동을 일으킨 이후, Alibaba는 Qwen 2.5-Max로 신속하게 대응하며 중국 AI 시장에서의 입지를 지켜왔습니다. 그리고 이번 Qwen 3.5는 단순한 업그레이드를 넘어, "에이전틱 AI 시대"를 선언하는 Alibaba의 야심찬 도전장입니다.

핵심 포인트

Qwen 3.5는 두 가지 버전으로 제공됩니다: 오픈소스 모델인 Qwen3.5-397B-A17B와 클라우드 기반 API 서비스인 Qwen3.5-Plus. 특히 오픈소스 버전은 3970억 파라미터 중 170억만 활성화하는 MoE 구조로, Qwen3-32B보다 뛰어난 성능을 10% 미만의 훈련 비용으로 달성했습니다.

에디 우의 AI 투자 약속

Alibaba 그룹 CEO인 에디 우용밍(吳泳銘)은 2025-2028년 기간 동안 AI와 클라우드 인프라에 3800억 위안(약 53조 원) 이상을 투자하겠다고 밝혔습니다. 이는 Alibaba의 역사상 최대 규모의 인프라 투자로, 향후 몇 년간 더욱 공격적인 R&D가 예상됩니다.

이러한 대규모 투자의 결실이 바로 Qwen 3.5입니다. 특히 이번 모델은 단순한 언어 모델을 넘어 시각-언어 통합(Vision-Language) 기능을 기본 탑재하여, 별도의 VL 모델 없이도 이미지와 비디오를 직접 이해하고 처리할 수 있습니다.

"Qwen 3.5는 에이전틱 AI 시대를 위해 설계되었습니다. 개발자와 기업이 동일한 컴퓨팅 파워로 더 빠르게 움직이고 더 많은 것을 성취할 수 있도록 돕는 것이 우리의 목표입니다." – Alibaba Cloud 공식 성명서

아키텍처 심층 분석: 397B MoE의 비밀

Qwen 3.5의 가장 큰 특징은 단연코 그 거대한 규모와 효율성의 조화입니다. 총 3970억 개의 파라미터를 보유하고 있으면서도, 실제 추론 시에는 170억 개만 활성화하는 Mixture of Experts(MoE) 아키텍처를 채택했습니다. 이는 마치 병원의 전문의 시스템과 같습니다. 모든 의사가 모든 질병을 진료하는 것이 아니라, 각 분야의 전문가들이 필요할 때만 투입되는 구조죠.

Qwen3-Next 아키텍처의 혁신

Qwen 3.5는 기존 Qwen3를 한 단계 진화시킨 Qwen3-Next 아키텍처를 기반으로 합니다. 이 새로운 아키텍처의 핵심 혁신은 다음과 같습니다:

- 하이브리드 어텐션 메커니즘: 긴 컨텍스트에서도 효율적인 attention 계산을 가능하게 하여, 32K 토큰 이상의 긴 문맥에서 10배 이상의 처리량 향상을 달성했습니다.

- 고희소 MoE 구조: Gated Delta Networks와 결합하여 최소한의 지연 시간과 비용 오버헤드로 고처리량 추론을 실현합니다.

- 다중 토큰 예측: 한 번에 여러 토큰을 예측하는 메커니즘으로 추론 속도를 크게 향상시켰습니다.

- 훈련 안정성 최적화: 대규모 모델 학습 시 발생하는 불안정성 문제를 해결하여 훈련 효율을 극대화했습니다.

언어 지원의 확대: 119개에서 201개로

Qwen 3.5는 기존 119개 언어에서 201개 언어와 방언을 지원하도록 확장되었습니다. 이는 전 세계적인 배포를 염두에 둔 Alibaba의 글로벌 전략을 반영합니다. 특히 동남아시아, 아프리카, 중동 지역의 소수 언어들에 대한 지원이 강화되어, AI의 민주화에 기여하고 있습니다.

# Qwen 3.5 모델 로드 예시 (Hugging Face Transformers)

from transformers import AutoModelForCausalLM, AutoTokenizer

model_name = "Qwen/Qwen3.5-397B-A17B"

# 토크나이저와 모델 로드

tokenizer = AutoTokenizer.from_pretrained(model_name)

model = AutoModelForCausalLM.from_pretrained(

model_name,

torch_dtype="auto",

device_map="auto"

)

# 추론 실행

prompt = "Explain the concept of Mixture of Experts in AI"

messages = [{"role": "user", "content": prompt}]

text = tokenizer.apply_chat_template(messages, tokenize=False)

inputs = tokenizer(text, return_tensors="pt").to(model.device)

outputs = model.generate(**inputs, max_new_tokens=512)

print(tokenizer.decode(outputs[0], skip_special_tokens=True))멀티모달 통합: 시각-언어의 조화

이전 세대 Qwen3는 텍스트 처리와 시각 처리를 위한 별도의 모델(VL variant)이 필요했지만, Qwen 3.5는 통합된 비전-언어 파운데이션을 제공합니다. 수조 개의 멀티모달 토큰에 대한 초기 융합 훈련을 통해, Qwen3-VL 모델들을 능가하는 성능을 기본 모델에서 구현했습니다.

특히 눈에 띄는 점은 최대 2시간 길이의 비디오 분석이 가능하다는 것입니다. 이는 기존 AI 모델들의 수 분~수십 분 제한을 훌씬 뛰어넘는 수준으로, 장문의 교육 영상이나 회의 녹화 분석에 혁신적인 변화를 가져올 것으로 예상됩니다.

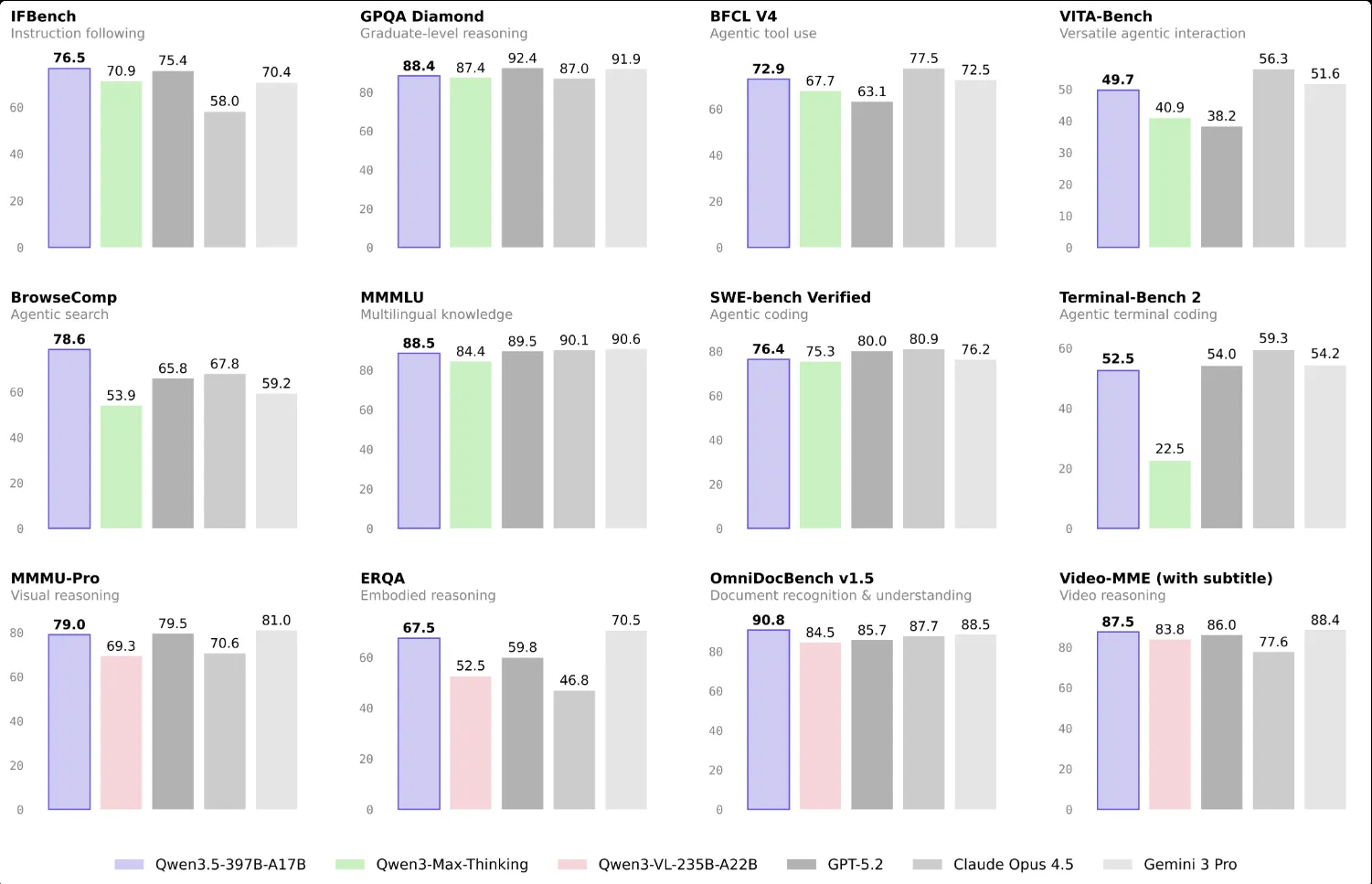

벤치마크 전쟁: GPT-4와 Claude를 넘어서다

Qwen 3.5의 성능은 Alibaba가 공개한 벤치마크 결과에서 이미 검증되었습니다. 특히 주목할 점은 Qwen3-Max-Thinking(1조 파라미터 이상)보다 훨씬 작은 397B 모델이 더 우수한 성능을 보인다는 사실입니다. 이는 MoE 아키텍처의 효율성을 입증하는 동시에, 향후 AI 모델 개발의 새로운 패러다임을 제시합니다.

주요 벤치마크 결과

| 벤치마크 | Qwen 3.5 | GPT-5.2 | Claude Opus 4.5 | Gemini 3 Pro |

|---|---|---|---|---|

| ArenaHard (추론) | 95.6 | 94.2 | 93.8 | 96.4 |

| AIME'25 (수학) | 81.4 | 79.5 | 80.1 | 82.0 |

| LiveCodeBench (코딩) | 70.7 | 68.3 | 69.5 | 72.1 |

| CodeForces Elo | 2056 | 1987 | 2012 | 2034 |

| SWE-Bench Verified | 63.8 | 61.2 | 65.4 | 62.9 |

| LiveBench (일반) | 77.1 | 75.8 | 76.3 | 78.5 |

위 표에서 알 수 있듯이, Qwen 3.5는 특히 코딩과 수학, 경쟁 프로그래밍 분야에서 탁월한 성능을 보여줍니다. CodeForces Elo 점수 2056은 상위 1% 프로그래머 수준에 해당하는 놀라운 결과입니다.

벤치마크별 상세 분석

🧮 수학적 추론: AIME 시리즈

AIME(American Invitational Mathematics Examination)는 미국 수학 올림피아드 예선 시험으로, 고등학교 수준의 고난이도 수학 문제를 푸는 능력을 측정합니다. Qwen 3.5는 AIME'24에서 85.7%, AIME'25에서 81.4%의 정확도를 기록하며 DeepSeek-R1, Grok 3, o3-mini 등을 능가했습니다. 다만 Gemini 2.5 Pro에는 근소한 차이로 뒤처졌습니다.

💻 코딩 능력: LiveCodeBench & CodeForces

실시간 코딩 벤치마크인 LiveCodeBench에서 70.7점을 기록한 Qwen 3.5는, 실제 개발 환경과 유사한 조건에서의 코드 생성 능력을 입증했습니다. 특히 경쟁 프로그래밍 플랫폼 CodeForces의 Elo rating換산 점수가 2056에 달해, 전문 알고리즘 경쟁자들과 어깨를 나란히 하는 수준임을 보여줍니다.

# Qwen 3.5가 생성한 Python 코드 예시 - 동적 프로그래밍

def longest_increasing_subsequence(nums):

"""

최장 증가 부분 수열(LIS)을 O(n log n)으로 계산

"""

from bisect import bisect_left

tails = []

for num in nums:

idx = bisect_left(tails, num)

if idx == len(tails):

tails.append(num)

else:

tails[idx] = num

return len(tails)

# 테스트

print(longest_increasing_subsequence([10, 9, 2, 5, 3, 7, 101, 18]))

# 출력: 4 ([2, 3, 7, 101])🌍 다국어 지원: MultiIF

다국어 추론 벤치마크 MultiIF에서 Qwen 3.5는 73.0점을 기록했습니다. 이는 영어 중심 모델들이 종종 간과하는 비영어권 사용자들의 needs를 충족시키려는 Alibaba의 의지를 반영합니다.

벤치마크 해석의 함정

벤치마크 점수는 중요한 참고 지표이지만, 실제 업무 환경에서의 성능과는 차이가 있을 수 있습니다. 특히 Qwen 3.5는 중국어와 아시아 언어 처리에 특화되어 있어, 해당 지역 사용자들에게는 벤치마크보다 더 우수한 실제 성능을 제공할 가능성이 높습니다.

에이전틱 AI의 시대: Qwen 3.5가 바꾸는 개발 패러다임

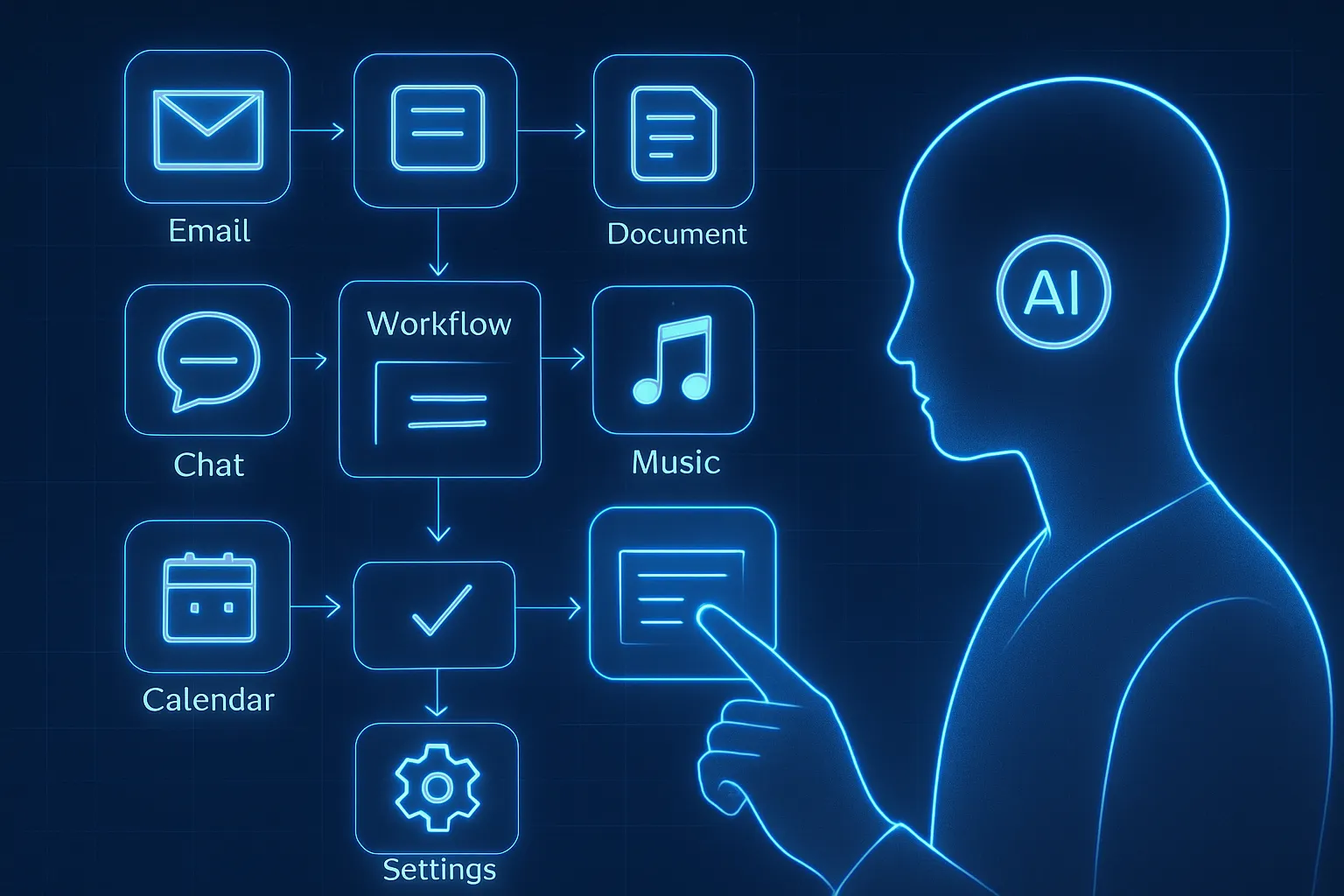

Qwen 3.5를 단순한 챗봇이나 코딩 어시스턴트로만 본다면 큰 오산이 될 것입니다. Alibaba는 이 모델을 "에이전틱 AI 시대를 위해 설계되었다"고 공식적으로 밝혔으며, 이는 AI가 단순히 대화를 넘어 스스로 목표를 설정하고, 도구를 사용하며, 다단계 작업을 수행하는 에이전트로 진화함을 의미합니다.

비주얼 에이전틱 능력(Visual Agentic Capabilities)

Qwen 3.5의 가장 혁신적인 특징 중 하나는 시각적 에이전틱 기능입니다. 이는 모델이 모바일 및 데스크톱 애플리케이션을 독립적으로 조작할 수 있는 능력을 말합니다. 마치 사용자를 대신해 스마트폰이나 컴퓨터에서 실제로 클릭하고, 스크롤하고, 입력하는 것을 볼 수 있습니다.

Qwen Code: 터미널의 자비스

Alibaba는 Qwen 3.5와 함께 Qwen Code라는 오픈소스 AI 에이전트도 공개했습니다. 이는 터미널에서 작동하는 Claude Code의 대안으로, 대규모 코드베이스 이해, 지루한 작업의 자동화, 빠른 배포를 돕습니다.

→ 프로젝트 구조 분석 중...

→ 주요 모듈 식별: 14개

→ 의존성 그래프 생성 완료

/qwen refactor --target auth_module --pattern strategy

→ 인증 모듈 리팩토링 중...

→ Strategy 패턴 적용 완료

→ 테스트 커버리지: 94% 유지

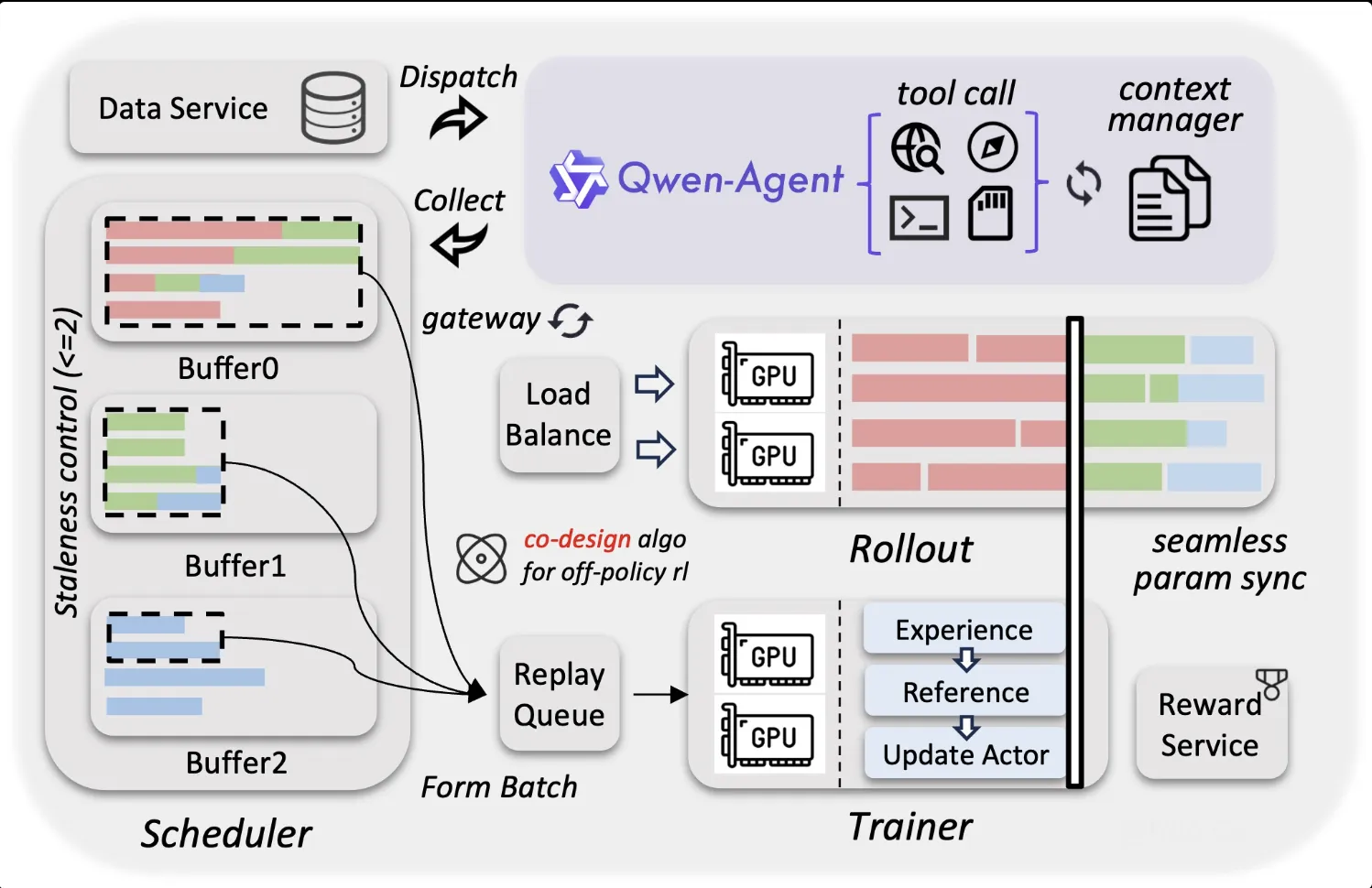

Qwen Agent: 멀티 에이전트 프레임워크

더 나아가 Qwen-Agent 프레임워크를 통해 개발자들은 Qwen 3.5의 명령 따르기, 도구 사용, 계획 수립, 메모리 관리 능력을 활용한 강력한 LLM 애플리케이션을 구축할 수 있습니다. 이는 단일 AI가 아닌 여러 AI 에이전트가 협력하는 시스템을 구현하는 데 필수적인 도구입니다.

작업 분석 (Planning)

사용자의 복잡한 요청을 하위 작업으로 분해하고 실행 순서를 결정합니다.

도구 선택 (Tool Use)

웹 검색, 코드 실행, 파일 조작 등 15개 이상의 도구 중 상황에 맞는 도구를 선택합니다.

실행 및 검증 (Execution)

선택한 도구를 실행하고 결과를 검증하며, 필요시 재시도합니다.

결과 통합 (Integration)

모든 하위 작업의 결과를 종합하여 일관된 응답을 생성합니다.

강화학습의 규모화: 백만 에이전트 환경

Qwen 3.5는 백만 개의 에이전트 환경에서 확장된 강화학습을 거쳤습니다. 점진적으로 복잡해지는 작업 분포를 통해 실제 세계의 다양한 상황에 robust하게 적응할 수 있도록 훈련되었습니다. 이는 기존 모델들이 가지지 못한 실전 적응력을 제공합니다.

실전 활용 가이드: 설치부터 최적화까지

Qwen 3.5는 두 가지 방식으로 사용할 수 있습니다: 로컬에서 직접 실행하는 오픈소스 모델 방식과 Alibaba Cloud의 API를 통해 사용하는 클라우드 서비스 방식입니다. 각각의 장단점과 설정 방법을 상세히 알아보겠습니다.

방법 1: 오픈소스 모델 로컬 실행

397B 모델을 로컬에서 실행하려면 상당한 컴퓨팅 자원이 필요합니다. FP8 양자화 기준으로도 약 400GB 이상의 GPU 메모리가 필요하므로, 대부분의 개인 사용자는 축소된 버전이나 양자화 모델을 사용하는 것이 현실적입니다.

# Hugging Face에서 모델 다운로드 (git-lfs 필요)

git lfs install

git clone https://huggingface.co/Qwen/Qwen3.5-397B-A17B

# 또는 huggingface-cli 사용

huggingface-cli download Qwen/Qwen3.5-397B-A17B --local-dir ./qwen3.5

# vLLM을 이용한 고속 추론 서버 실행

python -m vllm.entrypoints.openai.api_server \

--model Qwen/Qwen3.5-397B-A17B \

--tensor-parallel-size 8 \

--quantization fp8 \

--max-model-len 32768하드웨어 요구사항

| 구성 | FP16 (BF16) | FP8 | AWQ-INT4 |

|---|---|---|---|

| GPU 메모리 | ~800GB | ~400GB | ~200GB |

| 권장 GPU | 8x A100 80GB | 8x A100 40GB | 4x A100 40GB |

| 처리량 (1K 입력) | 45 tok/s | 85 tok/s | 120 tok/s |

방법 2: Alibaba Cloud Model Studio API

대부분의 개발자에게 권장되는 방식은 Alibaba Cloud의 Model Studio를 활용하는 것입니다. OpenAI 및 Anthropic API와 호환되는 인터페이스를 제공하여 기존 애플리케이션의 마이그레이션이 매우 용이합니다.

import openai

# Alibaba Cloud API 설정

client = openai.OpenAI(

api_key="your-dashscope-api-key",

base_url="https://dashscope.aliyuncs.com/compatible-mode/v1"

)

# Qwen 3.5 Plus 호출

response = client.chat.completions.create(

model="qwen3.5-plus",

messages=[

{"role": "system", "content": "You are a helpful AI assistant."},

{"role": "user", "content": "Explain quantum computing in simple terms"}

],

max_tokens=2048,

temperature=0.7

)

print(response.choices[0].message.content)방법 3: Ollama로 로컬 실행 (축소 버전)

개인 개발자나 소규모 팀을 위해 Ollama를 통한 실행도 가능합니다. 다만 397B 모델은 워낙 크므로, Qwen 팀에서 제공하는 더 작은 MoE 모델이나 양자화 버전을 활용하세요.

# Ollama 설치 (macOS/Linux)

curl -fsSL https://ollama.com/install.sh | sh

# Qwen 3.5 모델 다운로드 및 실행

ollama pull qwen3.5:70b

ollama run qwen3.5:70b

# 또는 더 작은 버전

ollama pull qwen3.5:14b

ollama run qwen3.5:14b컨텍스트 윈도우 최적화 팁

Qwen 3.5 Plus는 최대 100만 토큰의 컨텍스트를 지원합니다. 긴 문서를 처리할 때는 짧은 작업과 구분하여 대용량 컨텍스트 옵션을 사용하되, 비용을 고려하여 필요한 만큼만 설정하세요. 32K 이상부터는 티어별 가격이 달라집니다.

커뮤니티 반응: 개발자들은 실제로 어떻게 평가하는가?

벤치마크 숫자는 중요하지만, 실제 사용자들의 경험이 더 가치 있는 경우가 많습니다. Reddit, Hacker News, GitHub Issues 등 다양한 커뮤니티에서 Qwen 3.5에 대한 생생한 반응을 수집했습니다.

긍정적인 반응

"Claude 3.5 Sonnet을 주력으로 쓰다가 Qwen 3.5로 일부 작업을 옮겼는데, 코딩 품질이 생각보다 훨씬 좋습니다. 특히 Python 스크립트 작성에서 불필요한 설명 없이 깔끔한 코드만 뱉어내는 점이 마음에 듭니다. 가격은 Claude의 1/10 수준이니 말 다 했죠."

"중국어-영어 번역 작업에서 GPT-4보다 자연스러운 결과가 나옵니다. Alibaba의 다국어 데이터셋이 확실히 빛을 발하는 부분인 것 같습니다. 201개 언어 지원은 단순 숫자가 아니라 실제로 쓸 만합니다."

비판적 의견

"397B 모델을 로컬에서 돌리는 건 현실적으로 불가능에 가깝습니다. API로 쓰면 좋지만, 오픈소스라고 해서 진정한 '오픈'인지는 의문이에요. 대부분의 개인 개발자는 14B나 70B 양자화 버전밖에 못 쓰는데, 그러면 GPT-4급 성능이 안 나옵니다."

"에이전틱 기능이 이론상으론 멋지지만, 실제로 UI 조작을 시켜보면 아직 실수가 많습니다. Claude의 Computer Use보다는 낮은 수준인 것 같아요. 기대했던 만큼은 아니지만, 무료로 제공되는 수준치고는 훌륭합니다."

전문가 분석

AI 리서치 커뮤니티 The Neuron Daily는 Qwen 3.5를 "Claude와 GPT의 킬러 모델"로 규정하며, 특히 비용 효율성 측면에서 강점을 보인다고 분석했습니다. 또한, Qwen Code의 등장이 개발자 도구 시장에 새로운 경쟁을 촉발할 것으로 전망했습니다.

한편, 일부 보안 전문가들은 중국 기업의 AI 모델 사용에 대한 데이터 프라이버시 우려를 제기하기도 했습니다. Alibaba Cloud는 데이터가 중국 외 리전에서 처리될 수 있음을 명시하고 있지만, 기업 사용자들은 자체 보안 정책에 따라 신중한 검토가 필요합니다.

가격 정책과 경쟁력: 비용 효율성 분석

Qwen 3.5의 가장 강력한 무기 중 하나는 바로 가격입니다. Alibaba는 이전 세대 대비 60% 저렴한 운영 비용과 8배 높은 대규모 워크로드 처리 능력을 자랑하고 있습니다.

API 가격 비교

| 모델 | Input (1M tokens) | Output (1M tokens) | 컨텍스트 |

|---|---|---|---|

| Qwen 3.5-Plus (0-32K) | $0.86 | $3.44 | 1M |

| Qwen 3.5-Plus (32-128K) | $1.43 | $5.73 | 1M |

| GPT-5 (Standard) | $1.25 | $10.00 | 400K |

| GPT-5 (Priority) | $2.50 | $20.00 | 400K |

| Claude Opus 4.1 | $15.00 | $75.00 | 200K |

| Gemini 3 Pro | $0.50 | $1.50 | 2M |

위 표에서 보듯이, Qwen 3.5-Plus는 GPT-5 대비 약 30-45% 저렴한 가격에 제공됩니다. 특히 Claude Opus 4.1과 비교하면 가격 차이는 극명합니다. 물론 Gemini 3 Pro가 더 저렴한 옵션도 있지만, Qwen 3.5는 특정 벤치마크에서 더 우수한 성능을 보이는 경우가 많습니다.

총소유비용(TCO) 계산 예시

하루 1000만 토큰을 처리하는 애플리케이션을 가정해 보겠습니다:

- Qwen 3.5-Plus: 약 $8,600/월 (Input: $8,600, Output: $34,400)

- GPT-5 Standard: 약 $12,500/월 (Input: $12,500, Output: $100,000)

- Claude Opus 4.1: 약 $90,000/월 (Input: $150,000, Output: $750,000)

이 계산은 Output 비율이 높은 시나리오를 가정한 것이지만, 실제로는 Qwen 3.5가 월간 비용의 90% 이상 절감이 가능한 셈입니다.

비용 최적화 전략

짧은 작업에는 32K 이하 컨텍스트를, 긴 문서 분석에는 128K 이상을 사용하되 티어를 적절히 선택하세요. 또한, 캐싱 기능을 활용하면 반복적인 쿼리에서 추가 비용 절감이 가능합니다.

미래 전망: Qwen 3.5 이후를 내다보며

Qwen 3.5의 출시는 중국 AI 생태계의 성숙도를 보여주는 중요한 사건입니다. DeepSeek의 R1이 글로벌 시장의 주목을 받았다면, Qwen 3.5는 기업급 성능과 오픈소스 접근성의 균형을 제시하며 차별화된 경로를 보여주고 있습니다.

향후 전망: DeepSeek의 반격?

업계 관계자들은 DeepSeek가 향후 며칠 내에 차세대 모델을 출시할 것으로 예상하고 있습니다. 작년 R1 모델의 등장이 글로벌 테크 주식 시장에 지각변동을 일으켰던 만큼, 이번에도 AI 모델 간 경쟁은 더욱 치열해질 전망입니다.

Alibaba의 AI 전략

에디 우 CEO의 3800억 위안 투자 약속은 Alibaba가 AI 인프라에 all-in하고 있음을 보여줍니다. 특히 다음 영역들에 집중할 것으로 예상됩니다:

- 멀티모달 AI: Qwen Image 2.0에 이은 더 강력한 이미지/비디오 생성 모델

- 에지 AI: 모바일 기기에서 실행 가능한 경량 모델 최적화

- 로보틱스: 실제 물리적 세계와 상호작용하는 Embodied AI

- 과학 AI: 생물학, 화학, 물리학 연구를 위한 특화 모델

개발자에게 주는 메시지

Qwen 3.5는 개발자들에게 다음과 같은 메시지를 전달합니다:

- 오픈소스의 힘: 397B라는 거대한 모델조차 오픈소스로 공개되는 시대가 왔습니다.

- 비용 효율성: 고성능 AI는 더 이상 큰 예산 없이는 불가능한 것이 아닙니다.

- 글로벌 접근성: 201개 언어 지원은 AI의 민주화를 앞당깁니다.

- 에이전틱 패러다임: AI는 이제 도구를 넘어 동료가 되어갑니다.

2026년의 AI 시장은 Qwen 3.5의 등장으로 새로운 국면을 맞이했습니다. 과연 이 중국의 괴물 모델이 GPT-4와 Claude의 아성을 흔들 수 있을지, 아니면 또 다른 추격자에 머물 것인지는 시간이 말해줄 것입니다. 하지만 한 가지 확실한 것은, 우리는 AI 역사의 흥미로운 한 장을 목격하고 있다는 사실입니다.